El microchip del tamaño de un tablet que quiere revolucionar la inteligencia artificial

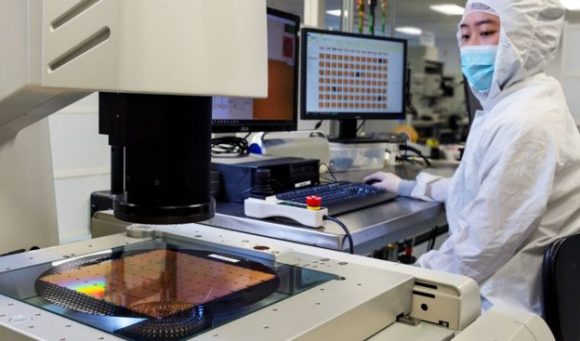

Un trabajador de Cerebras Systems inspecciona el chip mientras es manufacturado. Foto: BBC

Su tamaño es 56 veces más grande que el de los que existen en el mercado.

Una empresa con sede en California, Estados Unidos, dio a conocer lo que asegura es el chip de computadoras más grande del mundo.

El nuevo producto lleva por nombre Wafer Scale Engine (WSE) y, para hacernos una idea, es más grande que un iPad estándar.

Cerebras Systems, la compañía responsable de esta innovación, asegura que estas características sin precedentes serán útiles al ofrecer mayor capacidad de cómputo, más memoria y más ancho de banda para comunicaciones.

Esto haría posible que los desarrolladores de Inteligencia Artificial (IA) trabajen "a mayores velocidades y escalas que no eran posibles antes", afirman.

De hecho, la compañia dice que un solo chip será capaz de soportar sistemas complejos de IA en todas las áreas, desde los vehículos autónomos hasta los software de vigilancia.

Pero, a pesar de las bondades señaladas por sus creadores, algunos expertos tienen dudas sobre cuán práctica será la instalación de los nuevos dispositivos en muchos centros de procesamiento de datos.

¿Cuál es la importancia de una innovación como esta y cuáles podrían ser sus desventajas?

Más rapidez y menos requisitos de energía

Los chips informáticos se han vuelto más pequeños y más rápidos a lo largo de los años. Por lo general, son fabricados por docenas en una sola "oblea" de silicio, que luego se corta para separar unos de otros.

Las Unidades Centrales de Procesamiento (CPU, por sus siglas en inlgés) de escritorio más potentes poseen alrededor de 30 núcleos de procesador. Cada uno capaz de manejar su propio conjunto de cálculos, simultáneamente.

Por su parte, las Unidades de Procesamiento de Gráficos (GPU) tienden a tener más núcleos, aunque menos potentes. Esto tradicionalmente los ha convertido en la opción preferida para los procesos de IA.

Las GPU más potentes tienen hasta 5.000 núcleos. Pero el nuevo chip de Cerebras tiene 400.000 núcleos, unidos entre sí por conexiones de gran ancho de banda.

La firma asegura que esto le da una ventaja al manejar desafíos complejos de aprendizaje automático con menos retraso y menores requisitos de energía que sus antecesores.

Cerebras afirma que el WSE reducirá de meses a minutos el tiempo que lleva procesar algunos datos complejos.

Su fundador y director ejecutivo, Andrew Feldman, dijo que con su innovación la empresa había "superado desafíos técnicos de décadas".

"Reducir el tiempo de capacitación elimina un importante cuello de botella para el progreso de toda una industria", dijo.

¿Cuales son las desventajas?

Cerebras dijo que ya comenzó a enviar este hardware a un pequeño número de clientes, aunque se desconoce el precio de cada unidad.

Sin embargo, algunos expertos en tecnología han comenzado a sopesar las posibles desventajas de esta innovación.

Ian Cutress, editor sénior del sitio de noticias AnandTech, dice que la mayor rapidez que traerá el nuevo chip tendrá su costo.

"Una de las ventajas de los chips de computadora más pequeños es que usan mucha menos energía y son más fáciles de mantener frescos", explica.

Cutress sostiene que cuando se emplean chips más grandes como este, las compañías que los comienzan a usar necesitan una infraestructura especializada para soportarlos.

En su opinión, esto limitará el número de clientes para el nuevo producto, pues no todos podrán usarlo.

"Es por eso que es adecuado para el desarrollo de inteligencia artificial, ya que es donde se están moviendo grandes cantidades de dinero en este momento".

(Con información de BBC Mundo)

- Barco más grande del mundo rompe récord histórico

- Desmantelan primer cable submarino transatlántico del mundo que hizo posible Internet a nivel mundial

- El doble filo de la tunelización: Cuando esconder datos protege o destruye una organización

- Eclipse total de Luna será visible en Cuba el próximo martes 3 de marzo

- Putin en Foro de Tecnologías Futuras: “La ciencia avanza hacia la creación artificial de órganos humanos”

- ir aCiencia y Tecnología »

Mientras más se avance en la esfera de la inteligencia artificial, se pone en peligro la existencia de los seres humanos

Sigue viendo la matrix q te vas a quedar en la era de piedra

Trankilo Spielberg

Cien porciento de acuerdo con el profesor, una de las teorias de Stephen Howking es sobre la revolución técnologica y me parece que el señaló que está será en el 2030. Donde las máquinas tomarán el control... P.D: (Lo dijo Stephen Howking)

Como si no fuera el propio humano el que se pone en peligro.

Todo depende de en manos de quién esté.

Creo que no entiendes lo que quiere decir El Profesor, no estará en manos de nadie, solo de las máquinas.

Si personas con poder de decisión pensaran como usted el pais seguirá súper atrasado. La inteligencia artificial no hay quien la pare y es el futuro de la humanidad.

Si se imprimen en la IA las 3 leyes de Asimov, como éste lo hacía en sus obras, y se prohíbe la utilización de la IA en el sector militar, pienso q no tiene por qué ser así.

Muchos dicen que es improbable que las inteligencias artificiales sean un peligro para la existencia de la humanidad ya que estas se rigen por un grupo de líneas preprogramadas pero estos "protocolos" dependen de aquel que los introduzca también sus creadores no serán tan tontos como para darle acceso a estas nuevas tecnologías al sistema de armas nucleares a la primera, primero serán probadas en sistemas mucho más simples como en hogares y vigilancia pero para eso faltan muchos años.

No creo que sea la inteligencia Artificial la que ponga en peligro la existencia de los seres humanos, pero si pienso que seremos nosotros los desarrolladores del tal tipo de ciencia, los que plantaremos la base para nuestra autodestrucción y si la utilizamos con objetivo maléfico.

Y a pesar de las advertencias de no pocos estudiosos, siguen avanzando en lo de la inteligencia artificial y no parecen avanzar lo suficiente en métodos de control de dicha inteligencia artificial.

Parece que en los próximos años se hará realidad la IA, como en la película la Matriz no sé si han visto ese Films clásico, en donde los humano crean la primera inteligencia artificial hasta que se salió de control y se viraron contra los humano hasta extinguirlos en su totalidad, espero que estas compañías sepan lo que hacen o habrá exterminadores como Arnold Schwarzenegger.

Muchos avances tecnológicos,que no siempre se utilizan adecuadamente,la calidad de vida de los seres humanos no esta al mismo nivel del desarrollo que se esta alcanzando en lo tecnólogico.Slo para crecer en riquezas matriales y comodidades que estan afectando lo esencial del ser humano.No es que esté en contra del desarrollo y el avance es que no se usa como de verdad se requiere.

Jajajaja resulta interesante que varios comentarios refieren futuros distópicos. La inteligencias Artificial es solo un concepto. Hay muchas herramientas que ya son mucho más capaces que un ser humano en tareas específicas. Supongo que el miedo venga de la sensación de ser superados... Lo que de una manera u otra roza cuestiones Morales y éticas... Si ese es el caso, déjeme decirle que sería un logro humano poder comunicar sentimientos y emociones a un montón de circuitos. O tal vez es que temen que de lograrse tal cosa ya los humanos que nos creemos la meca de lo que existe, no tendremos ninguna razón real para seguir creyéndonos especiales.